3. Loss Function and Optimization

by 습관중독< 목차>

I. Loss function

1. Support Vector Machine (SVM)

2. Softmax

II. Optimization

1. Gradient Descent

2. 이미지 추출방식

ㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡㅡ

I. Loss function

1. Support Vector Machine (SVM)

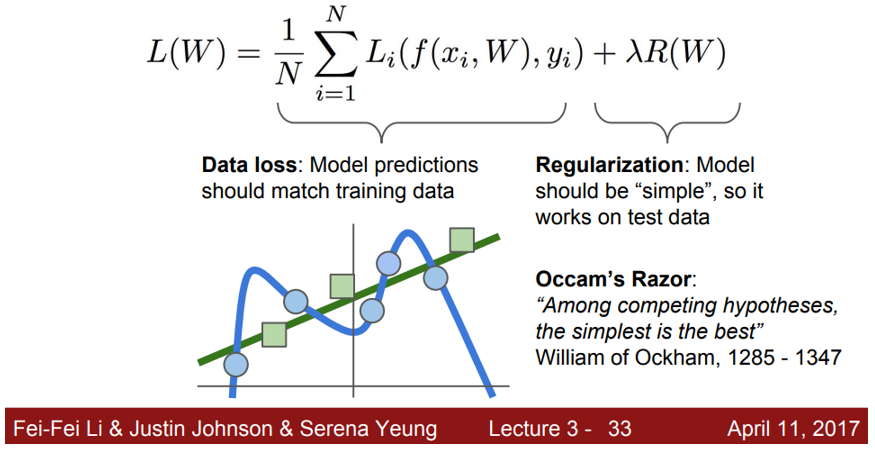

A. Data Loss

1) 고차원인 초평면(hyperplane)에서 결정경계를 기준(Decision boundary)으로 데이터를 분류

2) 결정 경계와 인접한 데이터 포인트를 Support Vectors, 이 서포트 벡터와 Decision boundary간의 거리를 Margin으로 지칭

3) 결과값 자체는 중요하지 않고, 그 상대적 차이(Margin)만 중요.

4) loss 값의 범위: 최소값=0, 최대값=무한대. loss는 class 갯수-1 만큼 나온다

5) W(Weight) 값 = Unique 하지 않다.

B. Regularization

1) Overfitting 방지

2) 특정 가중치가 너무 과도하게 커지지 않도록(weight decay) 학습시켜 Generalization(일반화) 성능을 높이는데 도움을 준다.

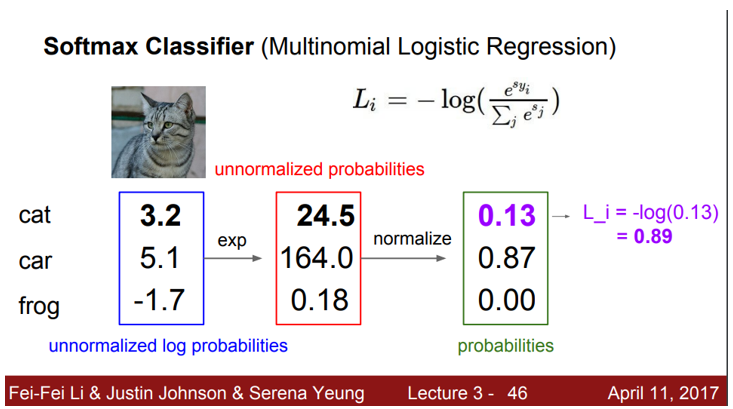

2. Softmax

1) 개요: 신경망 출력층에서 사용하는 활성함수로, 주로 분류문제에 사용

2) 구조: 점수 벡터를 클래스 별 확률로 변환하기 위해 흔히 사용하는 함수로 각 점수 벡터에 지수를 취한 후 정규화 상수로 나누어 총 합이 1이 되도록 계산

II. Optimization

1. 개념

1) optimization은 loss를 최소화 시킬 수 있는 weight를 찾는 것

2) 대표적인 방법으로 random search와 gradient descent

- random search: 간단하나, 시간 매우 많이 소요. 절대 이방식은 하지말 것

- Gradient Descent: 미분을 통해 간단한 코딩, 계산량 현격히 줄일 수 있음.

2. 이미지 추출방식

1) color histogram

- 기존의 이미지 추출방식: 원본 이미지 그대로 입력 -> 느리고 특징도 제대로 잡아내지 못함.

- 이미지 내의 컬러를 모두 픽셀로 파악하고, 그 컬러의 픽셀을 전체 파노라마에서 color bin이 몇개인지 갯수를 세어 feature를 추출하는 방식

2) HOG

8*8 픽셀로 구성된 구역을 총 9가지의 엣지의 bin으로 나눠서 9가지의 bin에 몇 개가 속하는지, edge의 의존도을 추출해낸 방식

3) NLP의 Bag 방식 활용

Bag of wards는 자연어처리(NLP)에서 주로 사용되는 방식으로, 이미지의 여러 지점 patch를 vector로 만들고, 사전화해 사전 내에서 가장 유사한 feature vector를 찾기

'스탠포드 CS231n: CNN강의 정리' 카테고리의 다른 글

| 6. Training Neural Networks I (0) | 2020.11.28 |

|---|---|

| 5. Convolutional Neural Networks (0) | 2020.11.21 |

| 4. Introduction to Neural Networks (0) | 2020.11.15 |

| 2. Image Classification (0) | 2020.10.17 |

| 1. CNN 소개 발표자료 (0) | 2020.10.09 |

블로그의 정보

습관을 애정한다

습관중독